Pierre Mounier, EHESS, OpenEdition Center (USR 2004, CNRS / EHESS / AMU / Avignon Université) et Didier Torny, CNRS, Institut Interdisciplinaire de l’Innovation (I3, UMR9217, CNRS / Mines ParisTech / Télécom ParisTech / École Polytechnique)

Les publications ont, depuis l’invention de la forme « revue » au XVIIe siècle, toujours servi de données à d’autres scientifiques. Comme le résume Christine L. Borgman, professeure en science de l’information, « la publication, comme compte rendu public de la recherche, est partie prenante d’un cycle continu de l’écriture, écriture, discussion, recherche d’information, enquête, présentation, dépôt et évaluation. Aucune publication académique n’existe seule» [1]. Mais les manières dont ces publications sont mobilisées et transformées en données sont variables et reposent sur des infrastructures toujours plus complexes.

La simple circulation des écrits scientifiques a, par exemple, conduit à élaborer la notion de moyenne. Face à des séries d’observations divergentes publiées dans différents articles en astronomie, il fallait produire des règles pour pouvoir en tirer le maximum d’informations en les rassemblant sous une seule mesure [2]. Mais on peut arguer que ce type de rassemblement des publications n’était alors pas systématique, notamment parce que la forme « article scientifique » n’était pas vraiment stabilisée avant la fin du XIXe siècle [3]. C’est à partir de cette époque que des formes systématiques d’analyse des publications sont apparues.

Ainsi, de très nombreuses disciplines ont développé des outils bibliographiques permettant aux chercheurs de repérer l’ensemble des publications — livres et articles de revue pertinentes sur leur sujet : Index Chemicus en chimie, Année Philologique ou Bulletin Annuel de l’Histoire de France, par exemple, en sciences humaines et sociales. Certaines disciplines ont poursuivi jusqu’à aujourd’hui l’analyse critique des publications, dans une perspective comparatiste. C’est le cas de l’anthropologie, qui encourage la transformation des publications en données, avec la base de données Human Relations Area Files, qui produit une indexation du contenu des publications, aujourd’hui au paragraphe près, selon des entrées multiples. Avec ce type d’outils, et les bases multidisciplinaires postérieures comme PubMed en sciences biomédicales, s’est développé un premier type de réutilisation systématique de littérature, souvent dénommée méta-analyse.

La « méta-analyse »

Le premier exemple, très célèbre, est celui du statisticien Karl Pearson, inventeur du coefficient de corrélation et du chi-square (ou khi-deux), qui a examiné l’ensemble de la littérature disponible sur l’inoculation de la typhoïde en 1904 [4]. C’est d’ailleurs dans ce domaine des essais cliniques que les méta-études ou la méta-analyse se sont le plus développées au cours de la deuxième moitié du XXe siècle. Il s’agit de limiter les biais de publication, d’acquérir une plus grande puissance statistique pour mettre à l’épreuve des résultats publiés. Il ne s’agit pas pour autant d’une opération machinique : la question essentielle est celle des critères de sélection des articles finalement retenus pour calculs statistiques, chaque publication étant considérée comme une donnée plus ou moins fiable. Cela a amené tant à des critiques radicales de la méthode comme sur-sélectionnant qu’à des développements méthodologiques très fins, notamment au sein de la Cochrane.

Au XXIe siècle, on voit apparaître deux autres formes d’utilisation systématique des publications comme données, qui ont un rapport opposé aux publications primaires. La première est née d’une crise de confiance dans les sciences expérimentales et vise à reproduire les expériences et résultats décrits dans les articles ; la seconde prend au contraire au pied de la lettre des données à l’intérieur des articles pour en produire de nouvelles connaissances. Mais toutes deux reposent sur des infrastructures informationnelles plus ouvertes, notamment par la mise à disposition des contenus dans des formats structurés (XML, HTML), non seulement lisibles mais aussi manipulables par des outils numériques à l’intérieur du document (illustrations, tableaux, références bibliographiques, citations).

Les études de reproductibilité

À partir des années 1970, des affaires publiques de fraudes scientifiques, qu’elles soient fondées sur le plagiat ou l’invention de données, mobilisent au-delà des communautés académiques [5]. Des formes nouvelles d’autorégulation sont progressivement inventées et mises en œuvre, que ce soit dans le domaine de l’autorat ou dans la responsabilisation des signataires des articles [6]. Cela n’empêche pas l’apparition de cas médiatisés à l’échelle mondiale, tel que celui du physicien Schön [7] ou du biologiste « cloneur » Hwang. Un très célèbre article de John Ioannidis conclut que la majorité des articles publiés est faussée par l’addition des différents biais identifiés, et qu’en conséquence, il est normal que les résultats ne soient pas ou soient mal reproduits [8]. Pendant que certains, notamment en étude des sciences, s’intéressent aux causes d’un tel phénomène (hystérisation de la publication, gestion des carrières, biais des revues…), d’autres tentent de mesurer le phénomène. Ainsi, la reproducibility initiative, d’abord lancée par Public Library of Science (PLOS), vise à financer et à publier des études spécifiquement dédiées à la reproduction d’expériences déjà publiées. Des initiatives collectives ont ainsi pu montrer qu’une majorité d’études en psychologie n’avait pu être reproduite [9].

L’agrégation massive de résultats

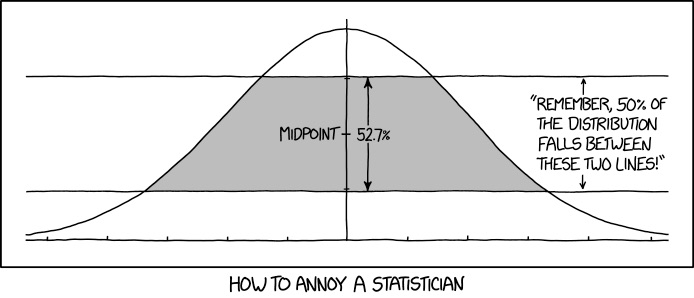

À l’opposé de ce mouvement qui demande de refaire un article à partir de l’ensemble des données décrites (méthodes, hypothèses…), le développement du text and data mining a conduit à l’exploration systématique du contenu des publications pour en extraire des données singulières, au lieu de s’intéresser aux « résultats » affichés par les auteurs des publications primaires. Pour prendre un exemple simple, une littérature grandissante s’intéresse aux p-curves, la distribution des p-values [10] dans une revue, une discipline, etc., qui furent d’abord manuellement collectées, puis extraites à partir de scripts informatiques ; les études menées ont permis de découvrir qu’il y a vraisemblablement des biais expérimentaux massifs — pour ne pas dire des arrangements avec les données — afin de dépasser le seuil de significativité communément choisi [11].

D’autres exemples plus constructifs existent, notamment dans la production d’ontologies stables et partagées, par exemple en biologie moléculaire [12]. Les questions du droit de fouille, des formats des articles, du codage des données dans la publication, des licences de diffusion sont au cœur de ces démarches. Ce mouvement est assez distinct de celui de la publication des données de tout article, puisqu’il permet d’une part de revisiter l’ensemble de la littérature publiée, dans une démarche différente de celle de la scientométrie [13], d’autre part de s’appuyer sur des formats serrés de la publication plutôt que de plonger dans les océans infinis des données de la recherche.

Des infrastructures au service d’une meilleure cumulativité en SHS

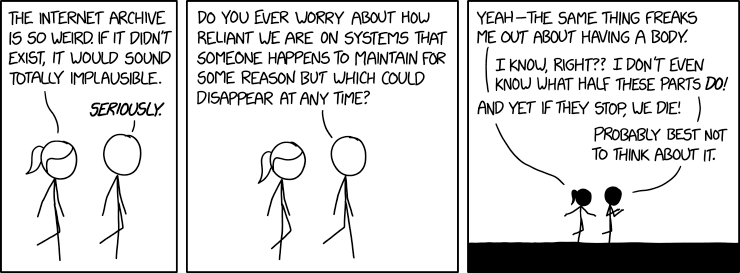

Pour mener ce même type de démarche vers d’autres formes d’usage des publications comme données, l’ouverture de nouveaux fronts de recherche en SHS suppose la mise à disposition d’outils de nouvelle génération permettant de découvrir l’ensemble des ressources disponibles en créant des relations intellectuelles à travers les barrières disciplinaires, linguistiques, temporelles et de format. En un mot, il s’agit d’offrir les outils exploratoires et analytiques de « lecture à distance » dont les SHS ont besoin pour redécouvrir, réinterpréter, remobiliser selon des perspectives inédites, un corpus déjà disponible mais totalement fragmenté [14].

Cela suppose de développer une indexation fine et partiellement automatique des contenus selon plusieurs index scientifiques utilisés par les communautés qui permette d’identifier les données embarquées au sein des publications, de relier données et publications et de fournir aux chercheurs des informations riches et vérifiées sur les contenus par l’intermédiaire de métadonnées et de métriques leur permettant de qualifier l’information. Le paradigme de la science ouverte implique aussi que le service soit ouvert à tous sans barrière technique, financière, disciplinaire ou institutionnelle et que les ressources qu’il indexe le soient aussi [15]. La prise en charge des outils d’écriture, d’édition et de publications, en un mot d’inscription matérielle des connaissances scientifiques, ne peut être déléguée à des opérateurs extérieurs à la communauté académique, comme c’est le cas aujourd’hui, mais doit être réintégrée dans le processus de recherche lui-même.

Texte publié en janvier 2019 dans La Lettre de I’InSHS.

[1] Borgman C. L. 2007, Scholarship in the Digital Age: Information, Infrastructure, and the Internet, The MIT Press (Chapitre 4 : The Continuity of scholarly Communication).

[2] Desrosières A. 1993, La politique des grands nombres: histoire de la raison statistique, La Découverte.

[3] Csiszar A. 2018, The scientific journal. Authorship and the politics of knowledge in the nineteenth century, University Chicago Press.

[4] Simpson R. J. S. & Pearson K. 1904, Report on certain enteric fever inoculation statistics, in The British Medical Journal : 1243-1246.

[5] Broad W. & Wade N. 1982, Betrayers of the Truth, Simon & Schuster.

[6] Pontille D. & Torny D. 2012, Behind the scenes of scientific articles: define the categories of fraud and regulate business, dans Revue d’Epidémiologie et de Santé Publique, 60(6) : 481-481.

[7] Reich E. S. 2009, Plastic fantastic: How the biggest fraud in physics shook the scientific world, Macmillan.

[8] Ioannidis J. P. A. 2005, Why Most Published Research Findings Are False, in PLOS Medicine 2(8): e124.

[9] Open Science Collaboration 2015, Estimating the reproducibility of psychological science, in Science 349(6251), aac4716.

[10] Probabilité pour un modèle statistique donné sous l’hypothèse nulle d’obtenir la même valeur ou une valeur encore plus extrême que celle observée.

[11] Bruns S. B. & Ioannidis J. P. A. 2016, P-curve and p-hacking in observational research, in PLoS One 11(2), e0149144.

[12] Kõljalg U., Nilsson R. H., Abarenkov K., Tedersoo L., Taylor A. F., Bahram M. & Douglas B. 2013, Towards a unified paradigm for sequence‐based identification of fungi, in Molecular ecology 22(21) : 5271-5277.

[13] Elle s’est concentrée sur les mots-clefs des articles, les auteurs et leurs institutions.

[14] Schonfeld R. 2018, One Platform to Rule Them All?, in The Scholarly Kitchen.

[15] Les développements de l’actuelle plateforme Isidore qui mobilise un ensemble de TDM et de contrôle manuel constitue un prototype de ces outils. Voir à ce sujet : Dumouchel S. 2018, The EOSC as a knowledge marketplace: the example of ISIDORE: A virtuous data circle for users and providers, EUDAT conference: Putting the EOSC vision into practice, Porto, Portugal.